Хочу сегодня опять вернуться к теме SEO оптимизации, которой в последнее время касался не так уж и часто, хотя на начальном этапе существования этого блога посвящал продвижению львиную долю времени. Тема эта волнует многих, ибо общие принципы СЕО просты и понятны всем, а вот детали, которые, собственно, и решают успех всей компании, известны далеко не всем или не все обращают на них внимание.

Говорить я буду в основном о продвижении под Яндекс, хотя в свете последних событий (алгоритм пингвин) оптимизация под Гугл тоже перестала быть простой и понятной всем. Отличительной чертой SEO 2012 можно назвать то, что сейчас тупое наращивание ссылочной массы не приносит желаемого результата и вполне может повлечь за собой негативное отношение поисковых систем.

Также и переспам ключевыми словами текстов статей или анкоров ссылок может приводить к вылету продвигаемых страниц из Топа или существенному понижению их ранжирования вплоть до пессимизации, фильтра или бана.

Seo вчера и сегодня

Когда я начинал знакомство с SEO в далеком 2009 году, все было совсем по-другому. Точнее уже тогда наметился перелом, но я использовал для обучения материалы написанные чуть раньше, а значит ориентировался уже на устаревшие идеалы. Понятие тошноты, процент вхождения ключевых слов, идеальный размер текста и прочие вещи уже канули в лету. Равно как и принцип — чем больше внешних ссылок, тем лучше. Нет, конечно же, какое-то влияние все же осталось, но оно уже не превалирует над остальными.

Раньше успешность продвижения на 4/5 определялось именно внешней оптимизацией, т.е. покупкой или получением бесплатных ссылок. А оставшуюся 1/5 успеха определяли качество ваших текстов (внутренняя оптимизация), а также возраст сайта и возраст обратных ссылок. Сейчас все в корне изменилось, да и вы, наверное, сами об этом прекрасно осведомлены.

Появился новый фактор ранжирования (четвертый кит, на котором стоит СЕО) — пользовательские (поведенческие) факторы. Для разных сайтов существуют, по мнению поисковиков (мы рассматриваем только Яндекс), разные модели поведения пользователей в поисковой выдаче и на самом ресурсе. И если ваш интернет проект в эту модель не укладывается, то и место в Топе ему будет не видать.

Кроме этого, оставшиеся три кита существенно изменили степень своего влияния — ссылки сдулись, а вот факторы времени и качества контента существенно подросли. Грубо говоря, сейчас все эти четыре основных фактора ранжирования вносят равный вклад в продвижение вашего сайта, что и подтверждает озвучиваемое многими специалистами несостоятельность однобокого подхода к продвижению, который имел место всего лишь несколько лет назад (ссылки купили и считайте, что вы уже в Топе).

Для некоммерческих проектов со значимостью внешних ссылок (в особенности покупных) складывается еще более неоднозначная и удручающая ситуация, которую я в полной мере ощутил на себе. Влияние покупных ссылок снизилось настолько, что об этом можно уже и забыть (в плане продвижения по некоммерческим СЧ и ВЧ запросам в Топ, а не в плане наращивания ТИЦ). Хотя возможны варианты, о которых, надеюсь, мы еще поговорим.

Технический аудит сайта

По традиции хочу начать с внутренней оптимизации (технический аудит, перелинковка, тексты), тем более, что на данный момент этот фактор, из четырех озвученных выше, имеет самый большой вес, хотя и не абсолютный. Как я уже не раз говорил, существует масса нюансов, которые могут мешать продвижению и лучше будет на эти грабли не наступать:

Тексты на сайте должны быть уникальными. Как я писал в предыдущей статье про плагиат и проверку уникальности текстов, добиться этого бывает не так просто как кажется, ибо существует такое понятие, как копипаст или воровство контента.

Но здесь я акцентирую внимание именно на том, что изначально тексты нужно не тырить (все равно получите за это заслуженный АГС рано или поздно), а писать самим или заказывать у профессиональных копирайтеров (в первую очередь это касается коммерческих проектов, конечно же). Контент для сайта можно заказывать, например, на биржах Етхт или Текстсейл, а для продвижения — на Адвего.

Если ваш сайт не является статическим (состоящим из Html файлов вебстраниц в чистом виде), а является динамическим (т.е. работает на каком-либо движке), то следует в файле robots.txt закрыть все лишнее (хотя бы файлы и папки самого движка) от индексации поисковыми системами.

Делать это нужно во избежании попадания мусора в индекс поисковиков (дублей контента в виде страниц для печати, RSS лент, профилей пользователей, страниц внутреннего поиска или результатов сортировки, дублей главной страницы через добавление к ней index.php или index.html). Не усложняйте жизнь поиску и он повернется к вам лицом.

Мы говорим про Яндекс, но вот Гугл, например, может игнорировать ваши указания в файлике robots.txt, что прискорбно. Однако, он выполняет указания из мета тега Robots, который можно прописать для каждой отдельной страницы вашего сайта. В разных CMS это можно сделать по-разному, но вот, например, в WordPress для этой цели существует очень удобный плагин All in One SEO Pack, который позволит запретить к индексации через мета тег Robots всякие дублирующиеся листинги, а также позволяет добавить учитываемый с недавних пор и Яндексом мета тег Canonical ко всем страницам сайта.

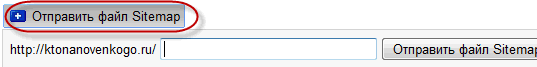

Добавьте своего питомца в панель Вебмастера от Яндекса (ну и в Гугл панель вебмастера тоже). Будете получать информацию о возникновении проблем на вашем ресурсе (например, заражении сайта вирусами или очередном апдейте поисковой выдачи Яндекса), а также получите в руки ряд дополнительных инструментов, о которых я довольно подробно рассказывал в статьях по приведенным чуть выше ссылкам. Например, сможете застолбить авторство своих текстов, хотя это пока и не учитывается напрямую поиском.

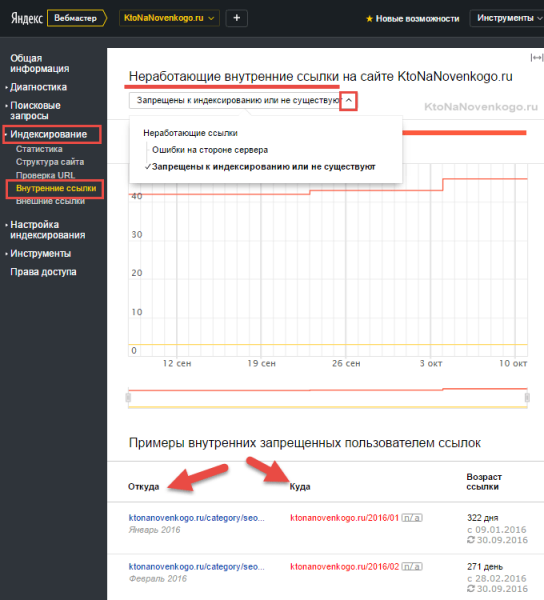

Там же через ЯВ можно отследить некоторые ошибки вашего сайта, например, страницы не имеющие заголовка Title или же имеющие одинаковые Тайтл, что не желательно. Можно будет найти битые ссылки на вашем ресурсе, а прямым просмотром всех проиндексированных Яндексом страниц найти среди них мусорные или дублирующиеся.

По возможности нужно сделать Html и CSS код вашего ресурса валидным (соответствующим общепризнанным правилам). Если в отношении языка стилевой разметки CSS по вопросу валидации проблем не возникает (можно воспользоваться русским валидатором), то по отношению к Html все не так однозначно, ибо стандарт Html 4.01 по версии W3C является сейчас последним из официально принятых стандартов, но уже во всю используются некоторые элементы Html 5, которые поддерживают браузеры, но валидатор будет выдавать по этому поводу ошибки.

Поэтому не нужно стремиться к абсолютно валидному Html коду, а использовать, например, русский валидатор для поиска таких ошибок, как не вынесенные в отдельный файл css и джава скрипт коды. Последнее поможет сделать код вашей вебстраницы наиболее информативным, ибо в нем будет гораздо больше полезного текста, чем вспомогательных элементов оформления в виде тегов, CSS правил и Джаваскрипт кода.

Кроме этого вынос CSS и Джаваскрипта в отдельные файлы (а затем и объединение этих файлов) поможет увеличить скорость загрузки вашего сайта.

Закрывание внешних и внутренних ссылок с помощью Nofollow или noindex не принесет вам особых дивидендов, ибо вес (pagerank) со страницы через них все равно уходит (хоть адресат его и не получает), а значит ссылки на другие страницы этого веса не дополучат. Избежать такой неприятной ситуации можно либо вообще не ставя эти ссылки (что не целесообразно в плане, например, юзабилити и ПФ), либо подгружать их на вебстраницу с помощью технологии Аякс (читайте тут подробнее).

Считается, что поисковики (во всяком случае Яндекс) пока такие линки не учитывают. Например, Сергей Сосновский около года назад провел эксперимент на своем блоге и скрыл весь свой сайдбар с помощью Аякса от поисковиков. Предварительно он списался с Платоном Щукиным и убедился, что сие действо не будет считаться клоакингом. Техническую часть этого безобразия реализовал, наверное, всем вам известный Димокс (кнопки социальных сетей share42 принадлежат его перу).

Сделать это не так сложно как кажется и уважаемый Димокс довольно подробно описал это на своем блоге. Другое дело, что Сергей Сосновский не почувствовал выхлопа от скрытия сайдбара в Аяксе.

Скорее всего это связано с тем, что поисковые системы по умолчанию различают сквозные ссылки из сайдбара и меню (или любых других сквозных блоков), практически не учитывая их при распределении статвеса. Однако, не сквозные блоки и ссылки можно будет с успехом подгружать с помощью Аякса, закрывая их индексацию поиском, но не понятно как долго это будет являться рабочим вариантом.

Ну и последним пунктом (но не последним по значимости) хочу отметить наличие осмысленных Url адресов страниц — так называемых ЧПУ (человекопонятных урлов). Это актуально, конечно же, только для проектов построенных на основе CMS, где в урлы включаются различные программные запросы.

Это не только уродует адреса страниц, но и в какой-то мере упрощает взлом сайта. Поэтому озаботьтесь на самой ранней стадии создания проекта настройкой ЧПУ в вашей CMS (читайте про ЧПУ в WordPress и SEF для Joomla). Если сайт уже давно и успешно существует без ЧПУ, то лучше будет все оставить как есть, ибо лучшее — враг хорошего.

Не все из вышеперечисленного я сделал на своем блоге, да и, наверное, не все упомянул, но вы можете сами посмотреть памятку, которую должен выполнить для себя любой вебмастер берущийся за продвижение своего или чужого проекта. Пунктов там очень много, но все они имеют значение и влияют на успех продвижения в той или иной мере.

Внутренняя оптимизация

Чуть выше я упомянул, что уже не стоит обращать серьезного внимания на частоту употребления ключевых слов, на размеры текстов, выделения ключей стронгами и т.п. вещи, ибо они уже не играют главенствующей роли. Это так, но поисковики по-прежнему не обладают интеллектом человека и им надо четко давать понять, о чем именно ваша статья и по каким поисковым запросам вы планируете продвигаться и занимать Топ выдачи. Надо и от этого никуда не денешься.

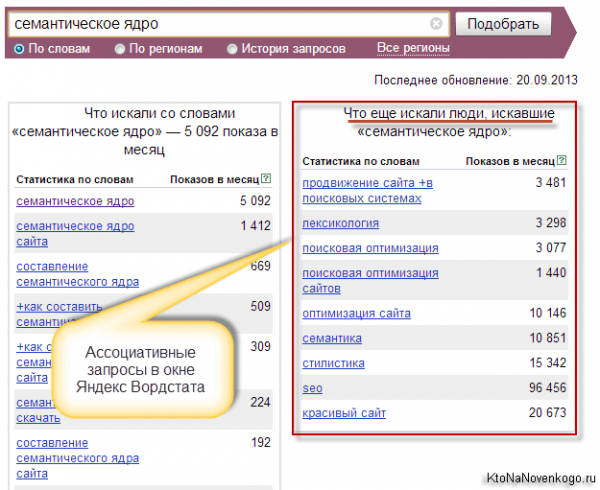

Вначале нужно будет составить семантическое ядро (подобрать поисковые запросы для всех страниц всего вашего сайта). Лично я для этого некоммерческого блога составляю ядро непосредственно перед написанием статьи (данная публикация не оптимизирована и не сможет привлекать ощутимый трафик с поисковиков, ибо ее задача состоит не в этом), но в случае проектов коммерческих это нужно будет сделать сразу для всего ресурса.

При продвижении под Яндекс лучше всего смотреть частоту поисковых запросов в его собственной статистике — Яндекс Вордстате. Более подробно про работу со статистикой поисковых запросов Яндекса и других поисковиков читайте по ссылке. Без семядра вы отдаете успех своего проекта на волю случая и по теории вероятности скорее всего проиграете и не достигнете тех высот посещаемости, которые позволят осуществлять успешные продажи или зарабатывать денежки на некоммерческом проекте.

Кроме продвигаемой страницы, на вашем ресурсе должны быть еще страницы с той же самой направленностью, т.к. это поможет в дальнейшем легче войти в Топ. Пример. Недавно я написал статью про QR-коды, предварительно подобрав семантическое ядро и следуя описанным чуть ниже правилам. Но шансов у нее выйти в Топ крайне мало, ибо других публикаций на сходную тему у меня на блоге не имеется.

Ну, а в силу того, что покупка ссылок (я фанат вечных в ГГЛ и статей в Миралинкс) для некоммерческих запросов сейчас не рулит, то и помочь ей я ничем не смогу. Даже внутренняя перелинковка не даст результата, опять же в силу отсутствия страниц с релевантным контентом.

То ли дело статьи по тематике SEO — здесь мне очень хороший задел удалось создать и можно пытаться уже что-то получать из поиска по этой тематике (например, статья про раскрутку сайта занимает хорошие позиции). Основной вклад в это, по моему мнению, внесли именно внутренние ссылки с релевантных запросу страниц. Не было бы релевантных страниц, не было бы и возможности внутренней оптимизации с помощью перелинковки.

Теперь по ключам, т.е. ключевым словам. Как я уже сказал — без них никуда, поэтому нужно будет обязательно употребить их в следующих элементах оформления вебстраницы, но при этом знать меру и соблюдать основное правило — естественность. Есть такая наука — статистика, которая при работе с большими массивами данных способна четко определить отклонение частоты употребления ваших ключевых слов в тексте от естественного.

Даже если у отдельных сайтов (например, моего блога) такой перекос имеет место быть, то это вовсе не говорит, что так и нужно делать. Присовокупится еще один какой-нибудь отрицательный фактор и будет проседание. Но давайте все же поговорим о том, куда надо красиво и лаконично вставлять ключи:

Удачи вам! До скорых встреч на страницах блога KtoNaNovenkogo.ru

Источник: ktonanovenkogo.ru