Несколько лет назад после введения алгоритма Пингвин в Гугле начало зарождаться «движение за чистоту рядов», что заставило задуматься многих вебмастеров и оптимизаторов об удалении не очень респектабельных ссылок, которые было закуплены на их сайты.

Хотя, в то время все же больше говорили о добавлении их в Disavow links, чем об удалении, ибо Яндекс на ту пору вполне лояльно относился к некачественной ссылочной массе и многие боялись, что удаление ее части (пусть и совсем никудышной) может привести к неприятным проседаниям трафика.

Сейчас же, после введения и постоянных обновлений алгоритма с говорящим названием Минусинск в Яндексе, движение «за чистоту рядов» стало, можно сказать, массовым. Но основная проблема тут состоит не в том, чтобы снять ссылки (хотя и с этим могут возникнуть проблемы), а в том, чтобы не ошибиться.

Дело в том, что снимать все подряд нельзя (не стоит предаваться панике и потом жалеть о потерянном навсегда трафике), а значит нужно как-то научиться делить ссылки на плохие и хорошие, чтобы снимать (по крайней мере в начале) исключительно плохие, которые кроме негатива ничего в себе не несут. Без автоматизации тут не обойтись, поэтому сегодня я и хочу как раз поговорить об одном из таких способов отделения зерен от плевел.

Вариантов решения этой проблемы несколько, но все они потребуют определенных денежных вложений за проверку ссылок (чем больше будет ссылочная масса вашего сайта, тем, естественно, это дело будет дороже). К тому же гарантированно сказать, что какой-то способ лучше других, заранее нельзя, посему «каждый выбирает для себя» (вполне возможно, что кто-то проводит оценку ссылочной массы в нескольких местах, а уже потом делает выводы на основе корреляции собранных данных).

Сбор всех ссылок в XTool для проверки их качества

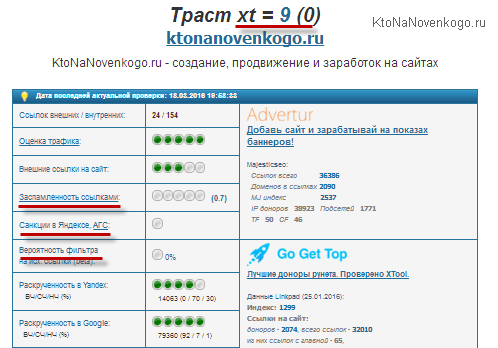

На данный момент я опробовал для решения задачи выявления плохих ссылок только одним из способов и именно его хочу подробно описать в этой статье (когда попробую другие, то их тоже опишу). В качестве основного инструмента я использовал Xtool. Многие, наверное, его знают хотя бы по тому, что там можно бесплатно оценить траст (и ряд других ключевых параметров — заспамленность, наличие АГС, вероятность попадания под фильтр и т.п.) своего сайта или ресурсов конкурентов, а также потенциальных доноров.

Собственно, именно для оценки потенциальных доноров (стоит с них покупать ссылку или лучше воздержаться) и использовали Xtool многие вебмастера и сеошники. Сейчас же, в силу упомянутых выше фильтров поисковиков за плохие ссылки, этот сервис многие стали использовать для обратной задачи — отбора плохих ссылок из уже имеющейся ссылочной массы с целью их последующего снятия для улучшения кармы сайта в глазах Яндекса и Гугла.

Естественно, что проверять всех доноров (страницы, с которых ведут на ваш сайт ссылки) было бы крайне утомительно. Посему в сервис была добавлена возможность массовой проверки ссылок на предмет «хорошая или плохая». Вот буквально так — сервис по умолчанию может для каждого бэклинка выдавать такой вердикт. В настройках вы можете это отключить и самостоятельно делать выводы о доноре на основании собранных сервисом данных, но на это нужно время и понимание вопроса.

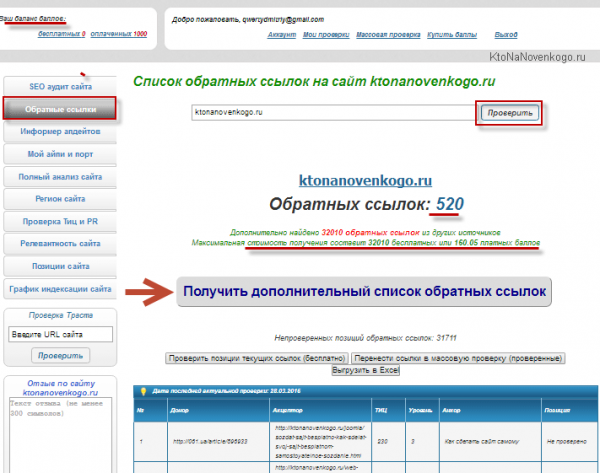

Естественно, что у вас может встать вопрос — где взять полный список всех проставленных на ваш сайт ссылок? Вариантов опять же масса. Можно что-то наковырять бесплатно (в панели Яндекса для веб-мастеров, в Google Search Console и еще других сервисах). Можно за денежку выдернуть этот список из сервисов подобных Ахревсу (правда, дороговато это может стоить, если ссылочная масса большая). Собственно, и сам Xtool предоставляется такую возможность на вкладке «Обратные ссылки«.

Как видно из скриншота, для моего блога сервис смог собрать из бесплатных источников около полутысячи ссылок, а получение остальных тридцати тысяч возможно на платной основе. Что примечательно, цена за это не слишком высока (за 32000 ссылок около 160 рублей), особливо если сравнивать с тем же Ахрефсом, где минимальный месячный абонемент стоит под сотню долларов.

Самом собой, что вы можете обойтись проверкой только бесплатных бэклинков, что позволит, скорее всего, какое-то количество плохих обратных ссылок отловить, но все же это капля в море. Посему лучше не жадничать, тем более, если от этого зависит выход сайта из-под фильтра или снижение вероятности его туда попадания.

Хотя оговорюсь, что собирать список проставленных на ваш сайт ссылок вы можете где вам удобно. По сути, это не принципиально, но делать в Xtool это удобнее, на мой взгляд, ибо можно будет оперативно и бесплатно проверить, а действительно ли эти ссылки проставлены до сих пор (т.е. провести их ревизию) или часть из них уже канула в лету и на их проверку нет смысла тратить деньги.

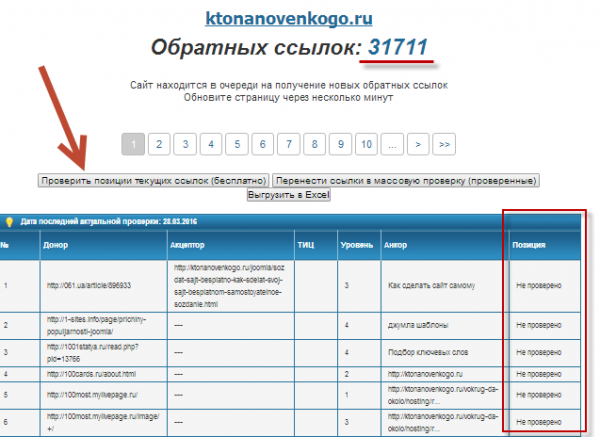

Итак, если вы на предыдущем шаге (см. скриншот выше) «побороли жабу» и нажали таки на кнопку «Получить дополнительный список обратных ссылок» (предварительно закинув на счет нужную сумму), то через минуту-другую вы будете лицезреть такую вот примерно «картину маслом»:

Обратите внимание на содержимое последней колонки. Там везде будет красоваться надпись «Не проверено». Что это значит? Ну, сервис выцепил список ваших беклинков, но какова его актуальность на данный момент? Можно, конечно же, и в таком виде его загрузить для дальнейшей проверки ссылок на предмет «плохая или хорошая», но лучше все же отсеять пустышки и не тратить на их проверку лишнюю денежку (имхо). Посему советую нажать на расположенную над таблицей кнопку «Проверить позиции текущих ссылок (бесплатно)».

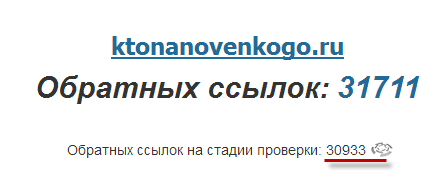

Процесс проверки ссылок «на наличие» не столь быстрый как их сбор, ибо каждую страницу нужно обойти, а когда их десятки тысяч, то времени может уйти достаточно много. Чтобы узнать, сколько еще осталось, обновите страницу и можете начинать медитировать наблюдая за убывающим счетчиком (либо забить и пойти попить чайку, как я сейчас и сделаю):

Правда, за время проверки я успел не только чаю попить, но и вторую часть статьи написать (про использование плагина Xtool_checker ). При этом заметил, что после полуночи скорость проверки ссылок существенно выросла, видимо высвободились мощности.

Поиск в XTool плохих ссылок ведущих на ваш сайт

Тем не менее результат был получен, и теперь в сводной таблице в последнем столбце «Позиция» напротив каждой из ссылок стоит «Есть» (ссылка присутствует) или «Нет» (ссылка уже исчезла). В моем случае «Нет» было достаточно много, а значит я не зря потратил время на ожидание конца проверки, ибо не будет пустых трат (уже денежных, а не временных) на проверку «пропавших» обратных ссылок.

Все, теперь можно смело жать на кнопку «Перенести ссылки в массовую проверку (проверенные)». Туда попадут только те ссылки, что помечены словом «Есть».

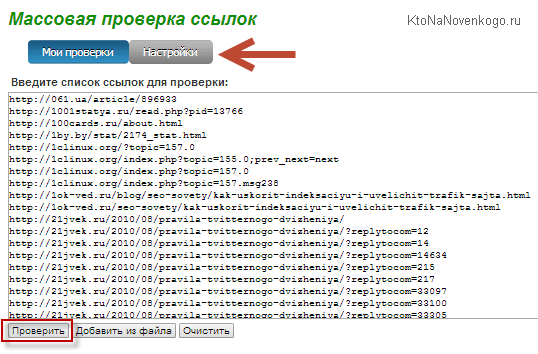

В Xtool откроется окно массовой проверки, в которое можно было бы попасть и по приведенной ссылке (это было бы актуально, имей вы на руках свежий и полный списков бэклинков вашего сайта).

Прежде чем нажать на расположенную внизу кнопку «Проверить», можете нажать на кнопку «Настройки»:

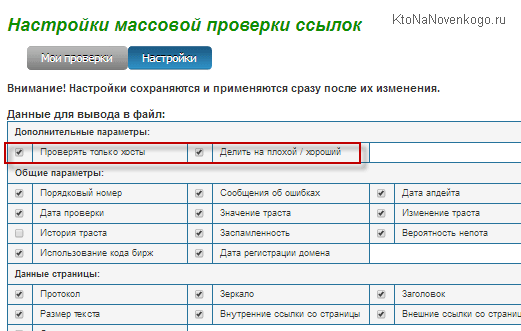

Настроек очень много, но обратить внимание советую только на две из них:

Но с другой стороны, на хорошем домене может быть размещена плохая ссылка. Посему я эту галочку снимаю. На самом деле, это может выйти не столь уж и накладно, ибо сначала проверяется качество домена, и если он помечается как «плохой», то дальнейшая проверка самого урла внутренней страницы уже не происходит для экономии ваших баллов. Только для «хороших» доменов будут пробиваться все ссылающиеся на ваш ресурс страницы. К тому же, если вы потом планируете загружать плохие ссылки в Google disavow links, то там нужны будут не домены, а конкретные адреса страниц.

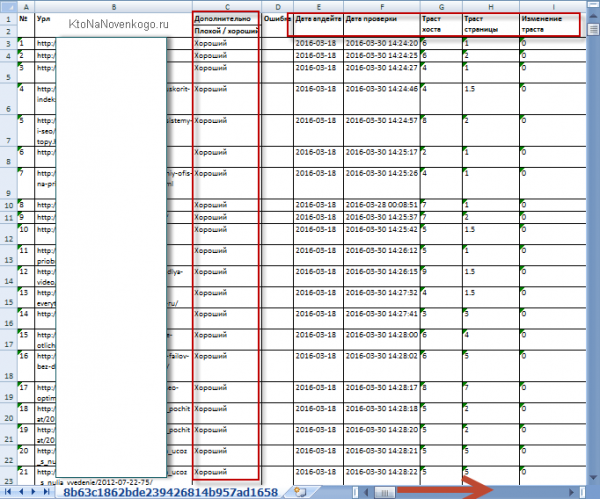

После запуска проверки внизу вы увидите счетчик с процентами выполнения, а после окончания сможете скачать файл со сводной таблицей результатов к себе на компьютер, чтобы подробно его изучить:

Собственно, ориентируясь на этот список можно будет потихоньку начинать снимать «плохие» ссылки, если это возможно. Ну, или можно их добавить в Дисавоу Линкс в панели для вебмастеров Гугла, если сайт попал только под Пингвин, но не под Минусинск. Это уже вам решать…

Как находить плохие ссылки с помощью плагина Xtool_checker?

Но кроме онлайн-версии у этого проекта есть еще и плагин для Фаерфокса (Xtool_checker), который позволяет провести оценку ссылок, например, прямо там, где вы их закупали (в Сапе и т.п.). Его тоже можно использовать для оценки ссылочной массы, особенно если вы ее закупали в крупных биржах. Либо можно просто загрузить в него список уже имеющихся у вас страниц, откуда проставлены ссылки на ваш сайт, а потом провести оценку их качества.

Что примечательно, большинство параметров с помощью плагина Xtool_checker можно пробить бесплатно (оплачивается только расчет XT и XTD — траста страницы донора и траста всего домена донора). Т.е. теоретически можно будет бесплатно получить хоть и не полноценную, но все же оценку качества ссылок. Хотя, именно XT и XTD являются ключевыми в оценке и без них трудно будет обойтись, чтобы эффективно отсеять зерна от плевел.

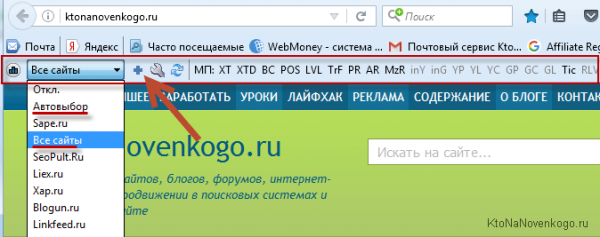

Плагин, как я уже упоминал, работает только под Фаерфоксом. Установить его можно с этой страницы. После установки и перезапуска браузера вы обнаружите в его верхней панели новую строчку с инструментами, которые туда добавил (стоит сразу зайти в меню настроек в виде гаечного ключа):

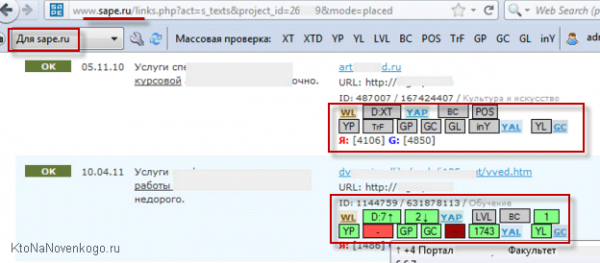

Фишка использования именно плагина (а не онлайн-сервиса) в том, что если вы, например, откроете в этом браузере страницу Сапы с потенциальными донорами (или уже купленными ссылками — наш случай), то выбрав из выпадающего списка плагина пункт «Для Sape» (или «Автовыбор»), вы добьетесь того, что в окне браузера рядом с сапа-ссылками появятся квадратики различных параметров, характеризующих качество этих ссылок.

Чтобы произошел съем значения достаточно будет кликнуть по нужному квадратику, а если нужен съем этого параметра для всех ссылок на открытой странице, то нужно будет уже кликнуть по соответствующей кнопке на панели плагина. Можно кликать сразу по нескольким кнопкам активируя тем самым многопоточный режим. Ну, и по результатам можно будет принимать решение «не отходя от кассы» (никуда не уходя с этой страницы Сапы) о том, хорошая эта или плохая (покупать ее или снимать). В общем, где-то так.

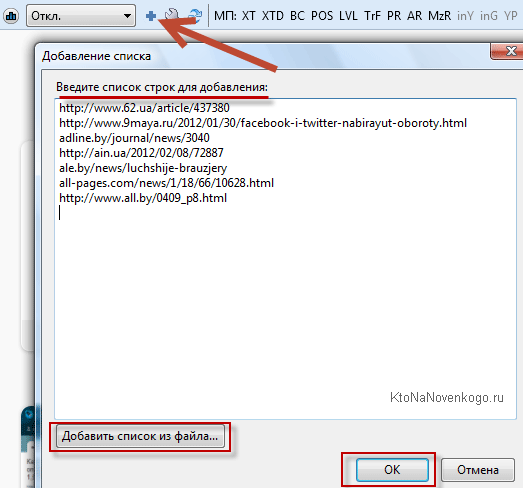

В нашем же случае (когда у нас на руках имеется список страниц ссылающихся на наш сайт) можно будет кликнуть по кнопке в виде плюсика справа от выпадающего списка и ввести в него Урл адреса страниц доноров, которые требуется проверить. Еще раз повторюсь, что для проверки параметров XT и XTD потребуется потратить денежку.

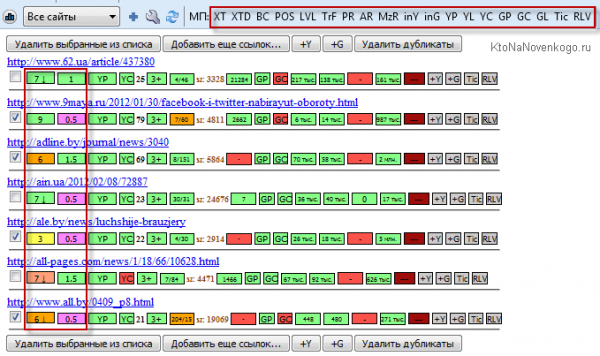

Цветовая гамма позволяет визуально оценить приемлемость данной ссылки (зеленый — хорошо, а остальное — не очень).

В плагине при проверке XT и XTD используются следующие цвета и обозначения:

Потом при желании вы можете экспортировать результаты в формат excel (кнопка EXP в правой части панели плагина). В результате получится сводная таблица характеристик доноров.

Стоит понимать, что параметр XTD (траст домена) рассчитывается с учетом большего числа параметров и по более сложному алгоритму, чем XT (траст конкретной страницы сайта, откуда на вас проставлена ссылка). Вполне естественно, что XTD обычно значительно больше XT, и это понятно. Ну, а XTD разбивает сайты примерно на такие категории:

При закупке ссылок следует ориентироваться на показатели выданные Xtool в таком порядке: сначала отбираем незаспамленные сайты с XTD >= 4 (ну, можно и от 3, если совсем все плохо), а затем отбираем уже на этих «хороших» площадках внутренние страницы с XT >= 2 для размещения своих будущих бэклинков.

При отсеве уже размещенных ссылок есть смысл использовать более мягкие условия — удалять бэклинки только со страниц, xt который меньше 1 (именно xt, а не xtd).

Удачи вам! До скорых встреч на страницах блога KtoNaNovenkogo.ru

Эта статья относится к рубрикам:

- Сервисы

Источник: ktonanovenkogo.ru